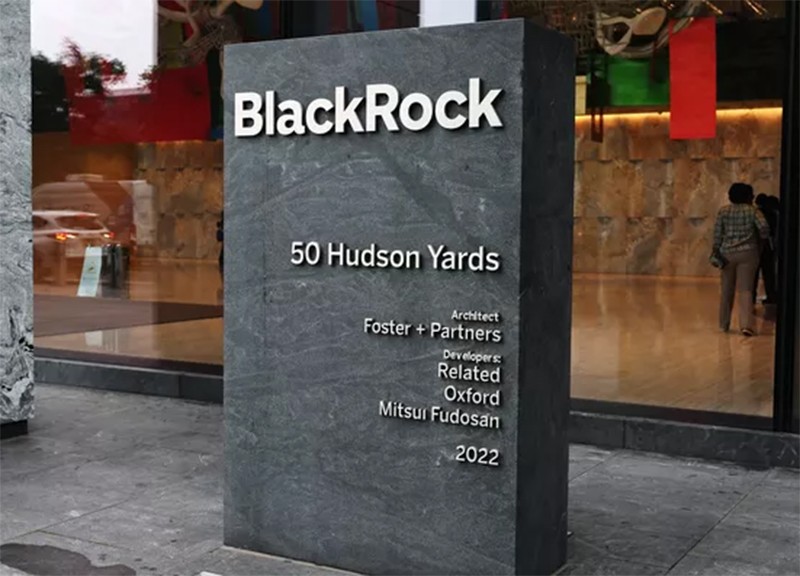

Le gérant d’actifs et le groupe technologique s’associent avec Abu Dhabi et plusieurs investisseurs pour financer les infrastructures nécessaires aux besoins très énergivores de l’IA.

Par Lucas Mediavilla, Le Figaro

Le rythme et l’importance des investissements dans l’IA continuent de donner le tournis. Mardi soir, BlackRock, le premier gestionnaire d’actifs du monde, Microsoft et d’autres investisseurs, dont le fonds MGX d’Abu Dhabi, ont annoncé la création d’un véhicule financier, Global AI Infrastructure Investment Partnership (GAIIP), avec l’ambition d’investir jusqu’à 100 milliards de dollars dans l’infrastructure d’IA - les data centers - ainsi que la production énergétique nécessaire à son alimentation. « Les besoins en data centers à l’échelle mondiale représentent plusieurs milliers de milliards de dollars à financer », justifie le patron de BlackRock, Larry Fink. « Les dépenses d’investissement nécessaires (…) dépassent ce qu’une seule entreprise ou un seul gouvernement peut financer », ajoute Brad Smith, le président de Microsoft.

Dans un premier temps, le GAIIP cherchera à débloquer 30 milliards de dollars de capitaux privés, auprès de gestionnaires d’actifs, d’investisseurs ou d’entreprises, avec l’idée derrière de pouvoir lever jusqu’à 100 milliards de dollars avec les emprunts. «Ces investissements dans l’infrastructure seront principalement réalisés aux États-Unis», indiquent également les membres de cette alliance. Ce n’est pas un secret, l'acquisition de la puissance de calcul pour faire tourner les modèles d’IA constitue un gouffre financier. Les analystes estiment qu’il faut débourser jusqu’à millions de dollars pour s'offrir ne serait-ce qu’un seul des derniers serveurs d’IA de Nvidia.

La consommation de l’électricité nécessaire pour faire tourner les data centers devient elle aussi un problème aigu. Les robots conversationnels et autres outils d’IA générative sont de véritables bombes énergétiques. Selon les experts, une requête sur ChatGPT consomme 10 fois plus l’électricité qu’une recherche classique sur Google. «Par rapport à une même recherche effectuée sur un moteur de recherche classique, utiliser un chabot d’IA revient à couper du pain avec une scie électrique », illustrait il y a quelques mois le président de l’Ademe, Sylvain Waserman.

Hausse exponentielle de la consommation d’électricité

En 2023, Google et Microsoft ont consommé à eux seuls pas moins de 24TWh l’électricité chacun, selon les chiffres compilés par le journaliste Michael Thomas. Un volume en forte hausse, qui représente l’équivalent de la consommation de pays comme la Slovaquie, l'Azerbaïdjan ou encore la Jordanie. La consommation électrique de leurs centres de données a fait exploser leur empreinte en matière démission de CO2, celle de Google ayant progressé de 48% en cinq ans, contre +30%pour pour celle de Microsoft par rapport à 2020.

À l’échelle mondiale, l’Agence internationale de l’énergie (AIE) estime que la consommation d’énergie des data centers pourrait doubler d’ici à 2026 par rapport à 2022, soit un niveau proche de l’électricité engloutie par un pays comme le Japon par exemple. Certes, tous ces TWh n’alimentent pas que les modèles d’IA. Mais l’AIE, qui estime que la part dévolue à ces technologies représentait à elle seule la consommation de 7,3 TWh l’an passé, «devrait connaître (d’ici à 2026, NDLR) une croissance exponentielle et consommer au moins dix fois la demande de 2023».

Au-delà de l'enjeu climatique se pose désormais la question du goulot d’étranglement lié à la capacité de produire ces électrons à grande échelle. Selon Mark Zuckerberg, PDG de Meta, c’est aujourd’hui la principale contrainte pour l'essor de l’IA, devant l'accès à la puissance de calcul informatique, autrement dit les puces. Elon Musk, lui, est persuadé qu’une pénurie d'accès à la ressource électrique menacé dès 2025. Sam Altman, le patron d’Open Ai, va plus loin et affirme que la massification de l’IA est inatteignable sans percée technologique majeure sur l’énergie (la fusion nucléaire entre autres).

L’annonce de partenariat entre Microsoft, BlackRock, le fonds d’Abu Dhabi et Global Infrastructure Partners tend évidemment à contourner le mur énergétique qui approche. Mais le problème est protéiforme: derrière l'investissement à consentir pour développer la production électrique se pose le sujet de l'accès au foncier, le raccordement aux réseaux électriques existants ou encore l'accès à l’eau, les data centers d’IA en consommant énormément pour refroidir les serveurs.

Aux États-Unis, qui concentrent 33% des implantations de data centers dans le monde selon l’AIE, le sujet est pris très au sérieux par Washington. Les tensions sur l'accès à l’énergie ou la ressource en eau se multiplient dans les États américains où sont implantés les géants de l’IA. La semaine dernière, des représentants de groupes comme Open Ai et Nvidia ont été reçus par l’Administration Biden, qui a décidé de créer un groupe de travail pour faciliter l'implantation des data centers. Le département de l’énergie a été chargé de se rapprocher des opérateurs ou propriétaires de ce type d'installations pour leur proposer des aides financières ou administratives.